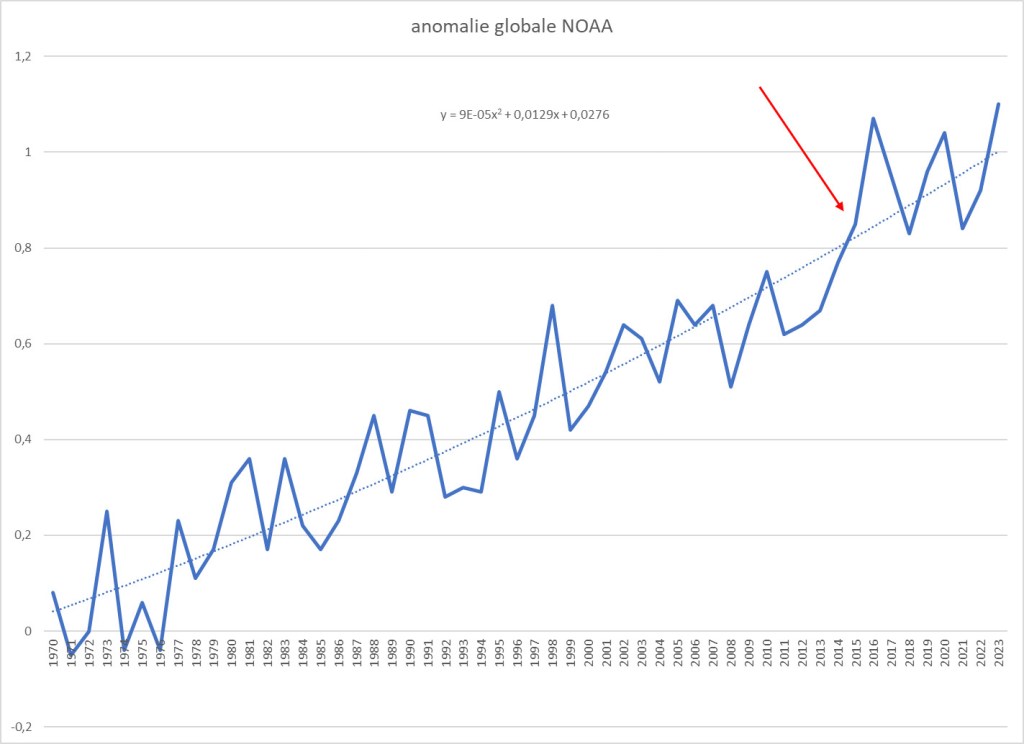

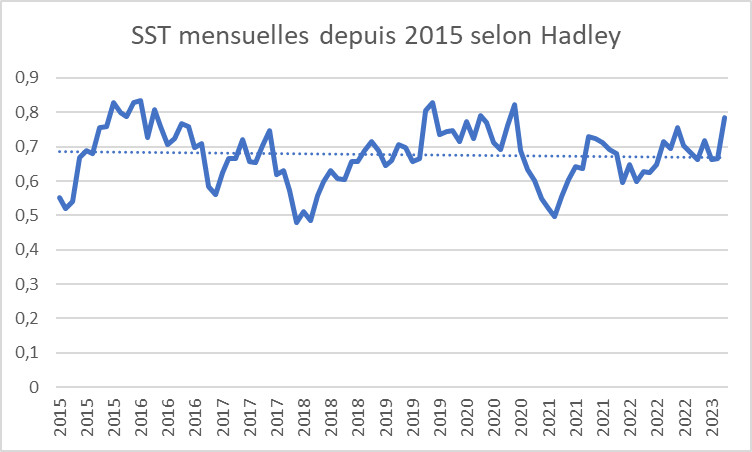

Oui la température globale actuelle pulvérise tous les records, c’est indéniable, au cours de l’année 2023 et au début de 2024.

Les températures de surface océanique (SST) n’ont jamais été aussi élevées et de très loin.

En effet, l’anomalie globale des SST a atteint au mois de septembre, 1.16°C, pour un précédent record à 0.91°C en janvier 2016, au plus fort de l’épisode El Niño.

0.25°C en plus ce la paraît peu, mais en climatologie c’est vraiment énorme.

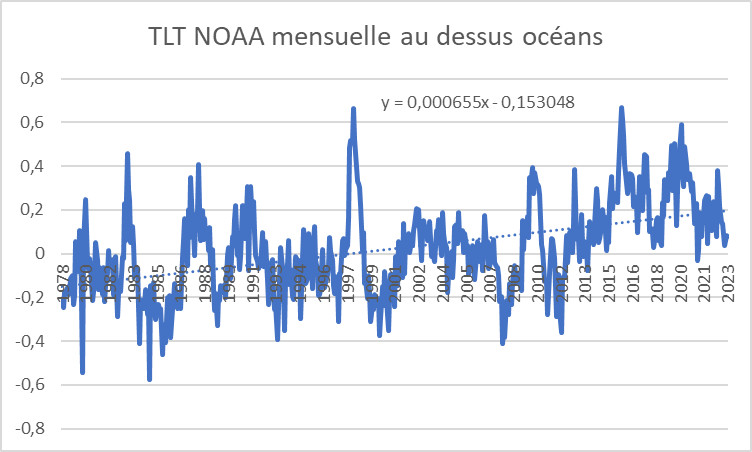

L’effet du réchauffement climatique de long terme n’explique que 0.11°C environ.

Donc que se passe t’il?

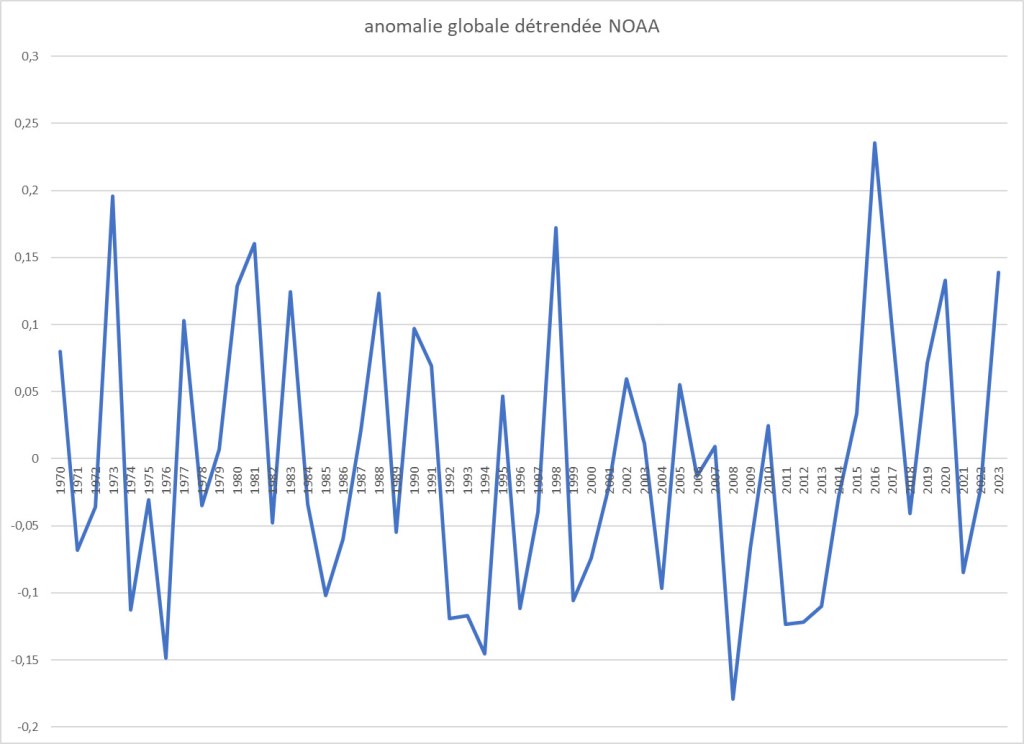

Si on examine la hausse pendant l’année 2023 on remarque qu’on a pris 0.3 à 0.4°C en 6 mois.

Aucun forçage externe ne peut expliquer une telle hausse, il faudrait imaginer un forçage de 10W/m2, soit 3% de la puissance solaire, ou 3 fois le forçage anthropique total accumulé depuis 1 siècle.

On a rien vu de tel ne serait-ce que par l’examen du bilan radiatif TOA.

On a vu fleurir des explications genre baisse des aérosols engendrés par le trafic maritime, ou encore vapeur d’eau dans l’atmosphère mais aucun d’entre eux, même leur addition ne parvient à ne serait-ce que le 1/10ème du forçage de 10W/m2 requis.

Il n’y a pas non plus d’explication côté rétroactions, cela se verrait aussi au bilan TOA.

Alors quoi?

J’ai mené mes investigations et il m’apparaît, calculs à l’appui, que le plus probable est une invasion massive d’eaux chaudes des couches profondes océaniques à la surface, avec sans doute, mais dans une moindre mesure, le fait qu’on est en phase positive de l’oscillation atlantique (AMO).

Cette invasion est un phénomène normal dans l’océan Pacifique équatorial à l’occasion des épisodes Niño.

Pourtant, en 2023, le Niño a certes été fort, mais pas exceptionnel.

Ceci du point de vue de son indice.

Cependant, on a eu pendant 3 ans, son contraire, la Niña, qui a sévi.

Une durée aussi longue est relativement rare, mais a du aboutir à une accumulation très importante d’eaux chaudes plus profondes.

Une analyse plus fouillée serait nécessaire pour bien étudier les évolutions des masses d’eau, mais pas mal de facteurs militent dans ce sens comme le fait que seule la couche 0-100m s’est réchauffée (comme les SST) alors que la couche 100-700m s’est refroidie.

On peut noter également que la chaleur océanique dans son ensemble s’est moins élevée en 2023 qu’en 2022, par exemple.

En conclusion, le fort réchauffement actuel est le résultat d’une phase positive de la variabilité naturelle océanique.

Il est probable que la température reprendra son évolution normale au cours de l’année 2024 et nous suivrons cela.

Nota: je ne mets pas pour le moment le détail de mes calculs et différents graphes.

Cela demande beaucoup de travail de mise en forme, mais si je constate un intérêt pour ce que je raconte, je pourrai compléter au besoin.